Analyse de la stratégie de crawl de Google

Gary Illyes a récemment déclaré sur LinkedIn son objectif de réduire le crawl. Bien que Google ait précisé que le volume global d’explorations reste stable, l’accent est désormais mis sur une exploration plus ciblée et efficiente.

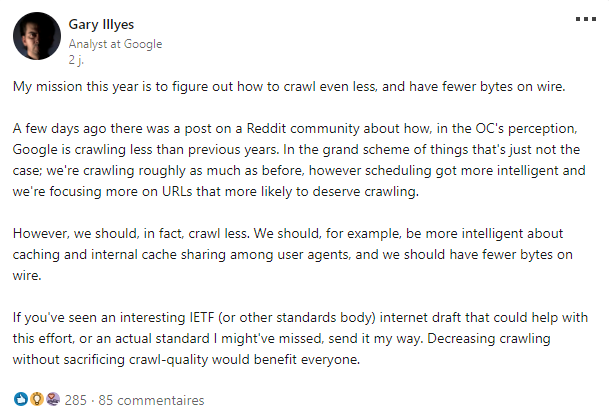

« Cette année, ma mission est de trouver un moyen de réduire le crawl, et la consommation énergétique de Google….Diminuer le crawling sans sacrifier la qualité du crawl serait bénéfique pour tout le monde. »

La qualité : le fer de lance Google

La volonté de Google de réduire le crawl s’inscrit dans une vision d’efficacité. En explorant uniquement les URL ayant le contenu le plus qualitatif, Google vise à améliorer la qualité de son index tout en limitant sa consommation de ressources. Cette approche favorise également une meilleure expérience utilisateur en dirigeant les internautes vers des contenus de qualité et pertinents.

Au cours d’un podcast, Google (toujours représenté par Gary Illyes) explique que le contenu de haute qualité est crawlé plus souvent. Gary Illyes révèle que la qualité du contenu, centrée sur l’utilisateur, est la clé pour augmenter la demande de crawl. Il n’y a pas de budget de crawl fixe auquel les sites web doivent se conformer, et Google donne la priorité au crawl en fonction de la qualité du contenu.

Le rôle de la demande de recherche

En effet, il est avéré que Google priorise le crawl en fonction de la qualité du contenu et des requêtes demandées. Gary Illyes explique que la décision de la quantité à crawler est basée sur le nombre de requêtes opéré sur une thématique. Si la demande de recherche diminue, cela se traduit également par une diminution de crawl. Ainsi, l’accent est désormais mis sur une exploration plus ciblée et efficiente, en tenant compte des tendances de recherche et de la pertinence du contenu.

Que faire pour son référencement SEO ?

La clé est de se concentrer sur la qualité et l’expérience utilisateur. En améliorant constamment la qualité des pages et l’utilité du contenu, il est possible de surmonter toutes les limites supposées sur le crawl. Cela implique une analyse des performances du site, l’identification des domaines à améliorer, et une fourniture de la meilleure expérience possible.

Les contenus sans intérêt seront de moins en moins indexés.